Изменения:- Добавлена возможность настройки правил анализа файла robots.txt при сканировании сайта в сервисе "Управление SiteMap"

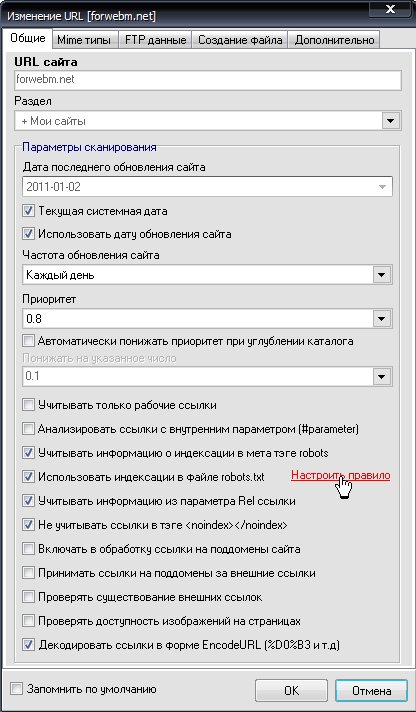

Настройка правила доступна из окна добавления/изменения параметров сайта.

Настройка устанавливается для каждого сайта в отдельности.

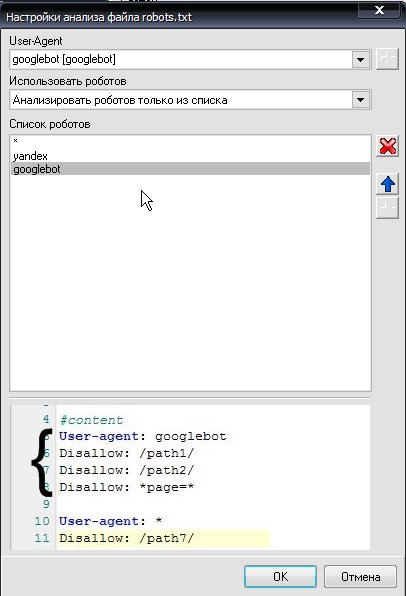

Вид окна настройки правил сканирования:

Правило позволяет установить список роботов, учет которых будет вестись при анализе запрета индексации при обходе сайта.

- Если Выбрано: "Использовать для анализа весь файл"

Будет анализироваться все содержимое файла robots.txt (все блоки роботов). При запрете индексации будет учтен первый из всех запретов.

Весь файл также будет анализироваться при любом другом типе анализа, если список роботов пуст.

- Если выбрано: "Анализировать всех роботов, кроме тех что в списке"

При таком типе анализа будут участвовать в анализе запрета все блоки роботов

(

например:

User-Agent: yandex

disallow: /

allow: /page

и так до следующего блока или конца файла..

)

кроме роботов, указанных в списке.

- Если выбрано "Анализировать роботов только из списка"

Будут учитываться блоки роботов только тех, которые указаны в списке.